Algoritmo disorientante, quando il censore non capisce quel che censura

Algoritmo disorientante, quando il censore non capisce quel che censura

Algoritmo disorientante, quando il censore non capisce quel che censura

La sera del 22 gennaio 2024 moltissimi creator che si occupano di salute mentale su Instagram hanno ricevuto una raffica di notifiche da parte di Meta, in cui venivano avvisati che alcuni loro post sarebbero stati messi in ombra. I messaggi contenevano un monito: i contenuti altrui che rispettano le linee guida – a differenza dei tuoi – potrebbero essere mostrati più in alto nel feed di chi ti segue. E se in casi come questi gli altri vengono spinti in cima dall’algoritmo, tu finisci in basso. Molto in basso. Tanto che nessuno riesce più a vedere i tuoi contenuti o quasi.

In molti si sono affrettati a verificare cosa contenessero i post incriminati e quali fossero le ragioni di questo shadowban annunciato, senza riuscire a trovare un filo logico che unisse i loro contenuti alle motivazioni e conseguenti azioni di Meta. Il primo pensiero, una volta scoperto che questa anomalia riguardava molti profili, è stato quello di un bug di sistema. Un bug è un temporaneo malfunzionamento della piattaforma, che tende a colpire nello stesso momento molti utenti con caratteristiche diverse. Questa simultaneità e questa eterogeneità sono però tipiche anche di un’altra situazione e cioè l’attivazione di una nuova funzione o di un aggiornamento, realizzati con l’intento di migliorare la piattaforma.

Il dubbio che Instagram avesse istruito l’algoritmo al riconoscimento di parole chiave legate alla salute mentale con l’intento di proteggere l’utenza più fragile – sbagliando però completamente l’obiettivo – è comparso nella mente dei creator più esperti e longevi, che ricordavano bene come una situazione simile si fosse già verificata in passato. «Nel 2019, più di 200 hashtag relativi alla salute mentale, fra cui #depression e #eatingdisorders, furono bannati dalla piattaforma. E le persone che online avevano trovato uno spazio sicuro, anche a livello informativo, si sono trovate sprovviste di un importante paracadute» racconta l’attivista Federica Carbone.

L’obiettivo dovrebbe essere quello di combattere disinformazione, fake news e contenuti pericolosi ma di fatto questi aggiornamenti tendono a colpire in modo indiscriminato chi utilizza alcune parole, a prescindere dal significato complessivo veicolato. L’intelligenza artificiale alla base dell’algoritmo social è infatti in grado di identificare parole (e loro combinazioni) spesso associate a contenuti disfunzionali ma non è in grado di valutare il contesto in cui vengono inserite. Accade così che i creator più furbi postino materiale potenzialmente molto pericoloso resistendo imperterriti nonostante le molte segnalazioni, mentre utenti meno maliziosi finiscano per essere oscurati nonostante non ci sia nulla di disfunzionale nei loro contenuti.

Trattandosi nello specifico di salute mentale, il danno non è irrilevante. Considerando che le stesse parole – inserite in contesti diversi – possono assumere significati e valenze opposte, sbagliare nel separare ciò che è buono (e dunque da salvaguardare) da ciò che è cattivo (e quindi da eliminare) diventa molto facile se dietro al computer non c’è un essere umano dotato di discernimento. Per quanto l’intelligenza artificiale rappresenti una grande conquista tecnologica, è evidente quanto la sua capacità di generalizzare rappresenti ancora un’arma a doppio taglio che deve essere moderata da qualcuno, non da qualcosa.

di Maruska Albertazzi

La Ragione è anche su WhatsApp. Entra nel nostro canale per non perderti nulla!

Leggi anche

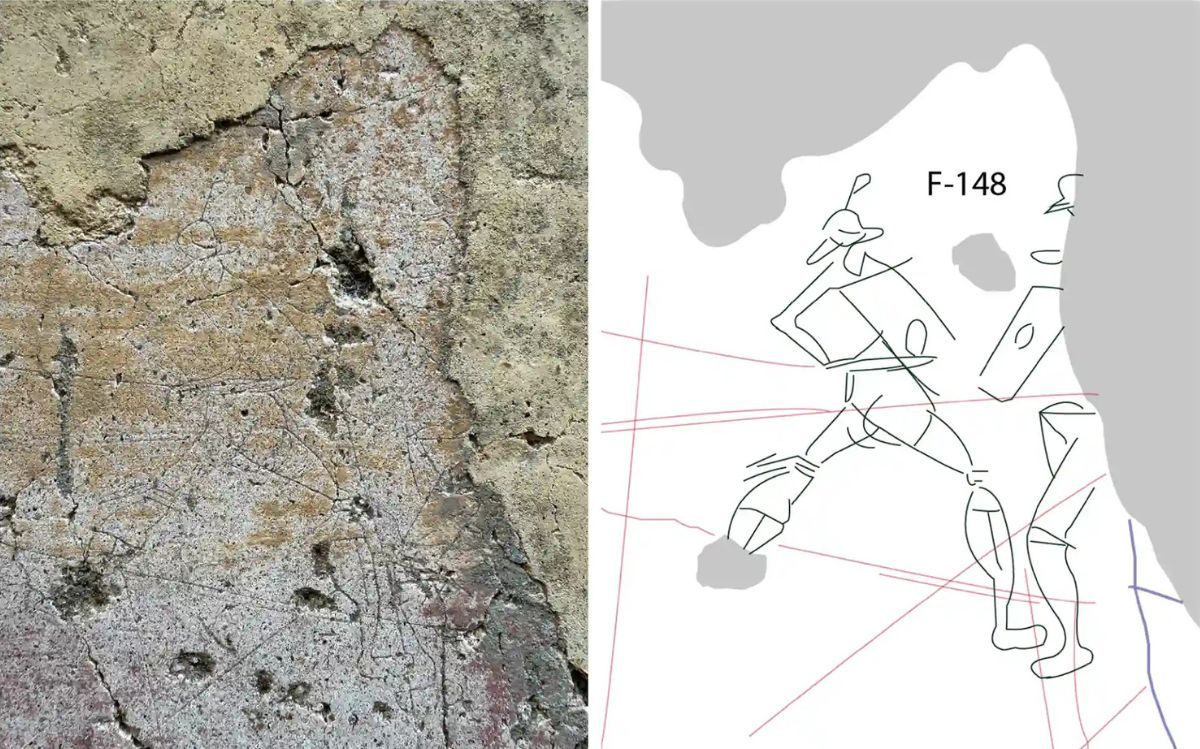

Le voci nascoste di Pompei riemergono grazie alla tecnologia

SpaceX acquisisce xAI: il piano di Musk per l’IA nello spazio

Auto cinesi sotto esame: allarme per la cybersicurezza