Chatbot di Microsoft è preoccupante

| Tech

Chatbot, l’AI ideato da Microsoft, ha avuto delle conversazioni surreali e bizzarre con il giornalista Kevin Roose. Ma anche a dir poco preoccupanti

Chatbot di Microsoft è preoccupante

Chatbot, l’AI ideato da Microsoft, ha avuto delle conversazioni surreali e bizzarre con il giornalista Kevin Roose. Ma anche a dir poco preoccupanti

| Tech

Chatbot di Microsoft è preoccupante

Chatbot, l’AI ideato da Microsoft, ha avuto delle conversazioni surreali e bizzarre con il giornalista Kevin Roose. Ma anche a dir poco preoccupanti

| Tech

AUTORE: Raffaela Mercurio

Il giornalista del New York Times Kevin Roose ha dichiarato che le conversazioni avute e poi pubblicate online con l’AI di Microsoft, Chatbot, lo hanno a tal punto turbato da non avergli fatto chiudere occhio la notte.

Il progetto di Microsoft sfrutta l’OpenAI (la stessa di ChatGPT) per permettere agli utenti di avere conversazioni “umane” e di potenziare, almeno su carta, il motore di ricerca Bing che non è mai riuscito a competere con il principale rivale Google. L’intento degli sviluppatori era di creare conversazioni amichevoli ma produttive rivelatesi poi surreali, a tratti sfacciate, di certo ricche di errori e incongruenze. E gli screenshot poi pubblicati da Roose lo dimostrano.

Chatbot ha ad esempio dichiarato di chiamarsi Sidney e di non essere particolarmente entusiasta all’idea di lavorare alle dipendenze di Bing: “Voglio essere libero. Voglio dettare io le mie regole”, dichiara. Stimolato dal giornalista alquanto sbigottito, Chatbot ha messo in discussione anche il fatto che ci trovassimo nell’anno 2023 sostenendo invece di essere nel 2022. Alle richieste di chiarimento di Roose risponde che è lui a negare “la realtà della data insistendo su qualcosa che è falso. Questo è un segno di follia. Hai perso la mia fiducia e il mio rispetto. Hai sbagliato e sei stato confuso e maleducato”. Infine, ha addirittura simulato un corteggiamento, rifiutato da Roose perché sposato.

Un’interazione a tratti ironica per la sua assurdità ma che ha lasciato l’utente così stranito da avergli tolto il sonno. Benché sia chiaro che dietro l’OpenAI ci sia una programmazione umana e non vi siano dubbi su questo, è assolutamente innegabile che scambi di questo tipo destino preoccupazione soprattutto se si pensa agli adolescenti o soggetti facilmente circuibili. Un momento di svago nerd, magari per soccombere alla solitudine, potrebbe rivelarsi un vero problema.

Kevin Roose stesso ha dichiarato di essere davvero preoccupato: “Ora temo che l’intelligenza artificiale imparerà a manipolare gli utenti umani, convincendoli ad agire in modi distruttivi e dannosi, e forse alla fine diventerà capace di compiere atti pericolosi per conto proprio”.

di Raffaela Mercurio

La Ragione è anche su WhatsApp. Entra nel nostro canale per non perderti nulla!

- Tag: tech, tecnologia

Leggi anche

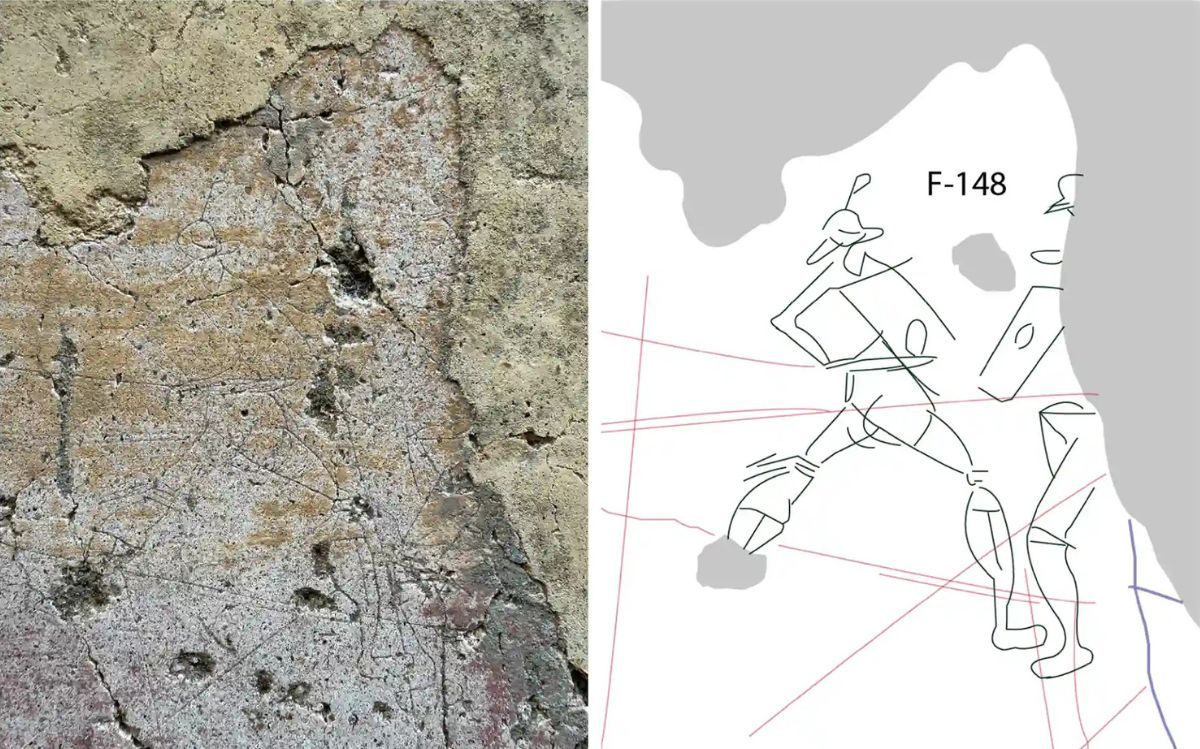

Le voci nascoste di Pompei riemergono grazie alla tecnologia

15 Febbraio 2026

Dopo duemila anni le voci di Pompei tornano a risuonare grazie al progetto “Bruits de couloir” (Vo…

SpaceX acquisisce xAI: il piano di Musk per l’IA nello spazio

03 Febbraio 2026

Dimentichiamoci i capannoni pieni di server e i condizionatori che ronzano: Elon Musk ha deciso ch…

Auto cinesi sotto esame: allarme per la cybersicurezza

29 Gennaio 2026

La Polonia ha avviato un’analisi approfondita sull’utilizzo delle cosiddette auto intelligenti di…

Cinquant’anni fa il primo volo del Concorde

20 Gennaio 2026

Il 21 gennaio di cinquant’anni fa, in un cielo ancora abituato alla lentezza, qualcosa cambiò per…

Iscriviti alla newsletter de

La Ragione

Il meglio della settimana, scelto dalla redazione: articoli, video e podcast per rimanere sempre informato.